Quelques anecdotes sur le développement du logiciel sur 90-40

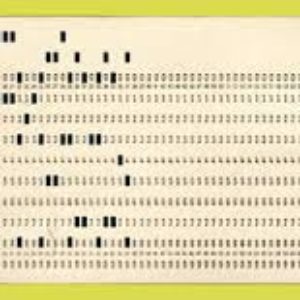

Les cartes perforées. Qui n’a pas connu, dans les années 70, les affres d’un paquet renversé lors des manipulations. Cartes qu’il fallait alors re-trier à l’aide du dernier listing disponible.…